第1回の記事でGCPと連携し、第2回の記事でGA4のデータを「蓄積」するスクリプトを作成しました。

GASでGA4データをスプレッドシートに自動取得!GCP設定からAPI連携まで、画像付きで丁寧に手順を解説します。手動での集計作業をなくし、データの自動蓄積とAI分析を実現する方法を学びましょう。...

しかし、第2回の状態では、まだ手動で「実行ボタン」を押す必要があり、せっかくの仕組みが自動化されていません。

最終回となる今回は、

- スクリプトを「トリガー」で完全自動化する

- 蓄積したデータを分析し、日々のSEO(検索エンジン最適化)活動に活かす

この2点を達成し、「自動でデータが貯まり、日々のサイト改善に役立つレポート」を完成させましょう。

目次

GASの「トリガー」で毎日データを記録

まずは、このスクリプトを「毎日決まった時間に自動で実行」するように設定します。この仕組みを「トリガー」と呼びます。

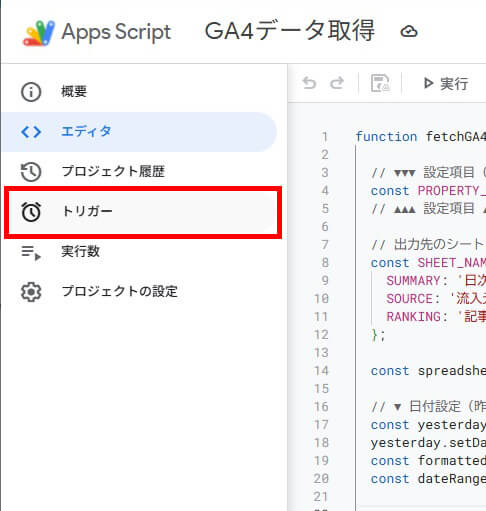

ステップ1:トリガー設定画面を開く

- GASエディタの左側にあるメニューから「トリガー」(目覚まし時計のアイコン)をクリックします。

- トリガーの管理画面が表示されます。

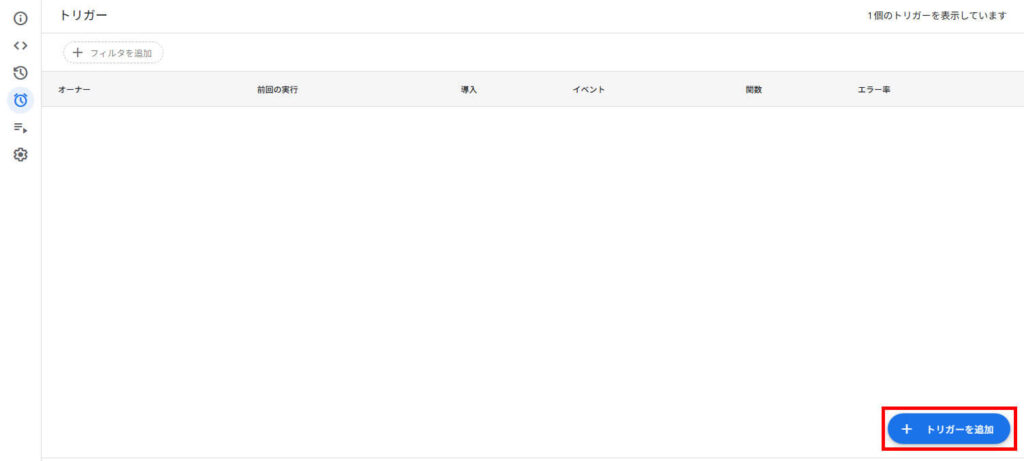

ステップ2:新しいトリガーを追加する

- 画面右下にある「+ トリガーを追加」ボタンをクリックします。

- 設定ダイアログが表示されます。

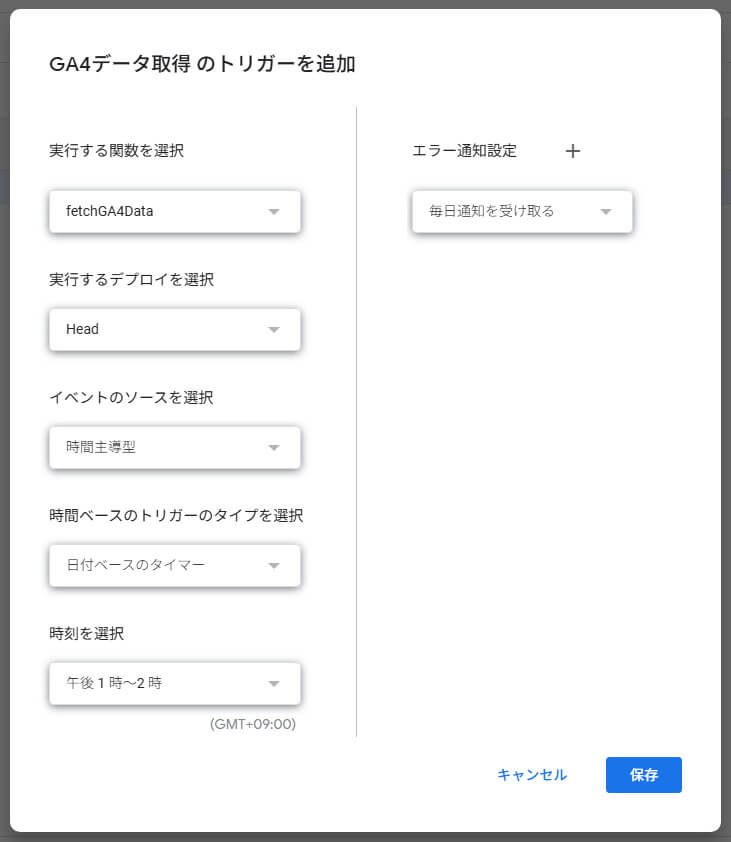

ステップ3:実行内容を設定する

ダイアログで、以下のように設定を行います。

| 項目 | 設定値 |

|---|---|

| 実行する関数を選択 | fetchGA4Data (第2回で作成した関数名) |

| 実行するデプロイを選択 | Head |

| イベントのソースを選択 | 時間主導型 |

| 時間ベースのトリガーのタイプを選択 | 日付ベースのタイマー |

| 時刻を選択 | 午後 1 時~ 2 時 (お好きな時間) |

※日付が変わった直後はGA4のデータが反映されていない場合があるため、時間をおいて記録するようにして下さい

ステップ4:保存する

- 設定が完了したら「保存」ボタンをクリックします。

- もし再度「承認」を求められた場合は、第1回と同様の手順で承認してください。

これで、GASが毎日午後1時~2時の間に自動で fetchGA4Data を実行し、スプレッドシートに前日のデータを1行ずつ追加(蓄積)してくれるようになりました。

AI分析がもたらす3つの視点

せっかく自動でデータを集めても、ただスプレッドシートを眺めるだけではサイトは成長しません。

しかし、膨大な数字の羅列から「改善のヒント」を人間が見つけ出すのは、時間もスキルも必要です。

そこで役立つのが、スプレッドシートに搭載されたAI「Gemini」です。

AIにデータを読ませることで、以下の3つの高度な視点が得られます。

リスク管理としての「異常検知」

- 分かること: 「特定の日だけCV(成果)率が急落している」「主力記事への流入が止まっている」といった、致命的な機会損失の兆候。

- 活用例: サーバーダウンやリンク切れなどのトラブルを早期発見し、売上や信頼の損失を最小限に抑える。

顧客解像度を高める「行動分析」

- 分かること: 「検索流入のユーザーは熟読しているが、SNS経由は直帰率が高い」など、チャネルごとのユーザーの質(LTVの可能性)。

- 活用例: 費用対効果(ROI)の高い集客チャネルを特定し、広告費や運用リソースを最適配分する判断材料として活かす。

既存資産の価値を最大化する「リライト戦略」

- 分かること: 「過去の記事だが、エンゲージメントが高くコンバージョンに近い」といった、埋もれている優良コンテンツ。

- 活用例: 新規記事を量産するよりも、既存記事のブラッシュアップ(リライト)だけで成果を伸ばす「高効率な施策」の立案。

それでは、これらを実際に引き出すための「プロンプト(AIへの指示文)」を見ていきましょう。

AI分析の具体的なプロンプト

前章で解説した「3つの視点」を実際に業務で活用するための、具体的な指示方法(プロンプト)を見ていきましょう。スプレッドシートのGemini機能を使えば、複雑な計算式を組むことなく、チャットによる対話だけでこれらの高度な分析が可能になります。

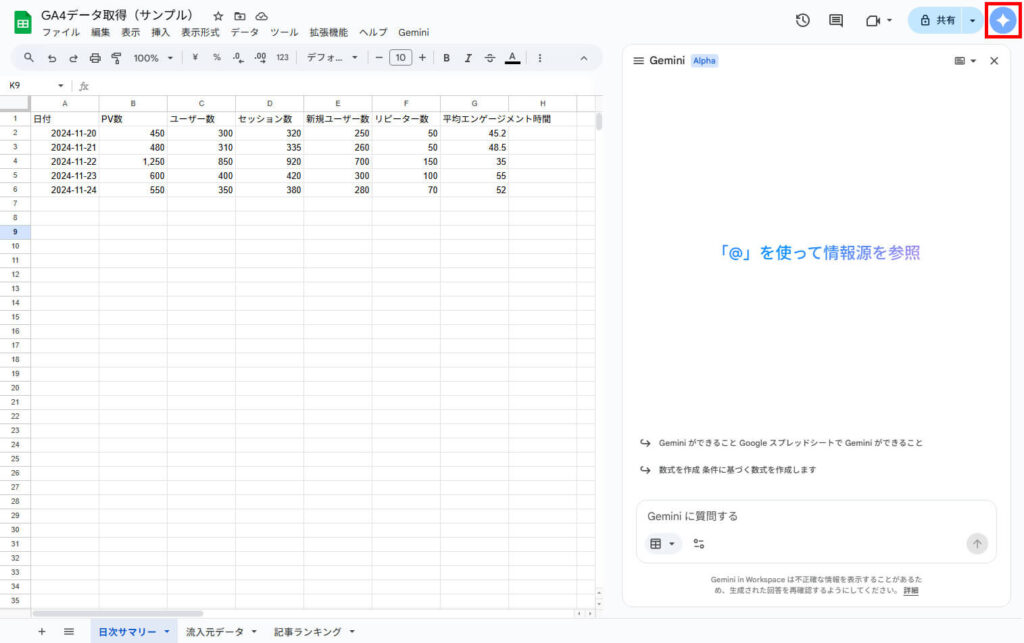

スプレッドシートの画面右上にあるGeminiのマークをクリックすると、右側にGeminiのパネルが表示されます。

※スプレッドシートでGeminiを利用するためにはGemini for Google Workspace等の契約が必要です。

第2回で作成した各シート(「日次サマリー」「流入元データ」「記事ランキング」)に対し、どのような質問(プロンプト)を投げれば回答が得られるか、4つの実例を紹介します。

1. サイト全体の状態把握(日次サマリー)

まずは「日次サマリー」シートを使って、サイト全体で何が起きているかを確認します。

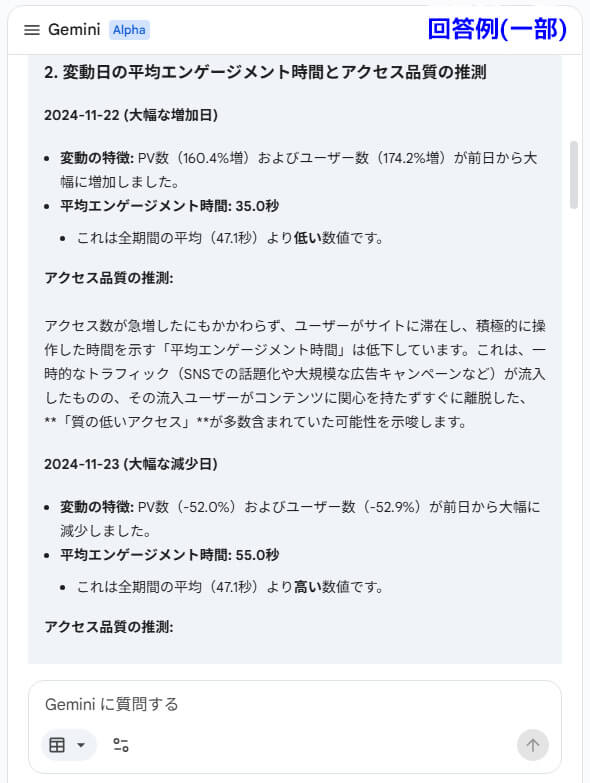

異常値(スパイク)の発見と原因推測

「昨日、急にアクセスが増えた(減った)?」という変化は、チャンスやトラブルの予兆です。

手順: 「日次サマリー」シートのデータ全体を選択し、以下のプロンプトを入力します。

また、その日の『平均エンゲージメント時間』に変化はありますか?数値の特徴から、質の高いアクセスだったか推測してください。

得られる分析: 単に「増えた」だけでなく、「じっくり読まれた(質が高い)」のか、「一瞬で離脱された(質が低い)」のかまで分かります。

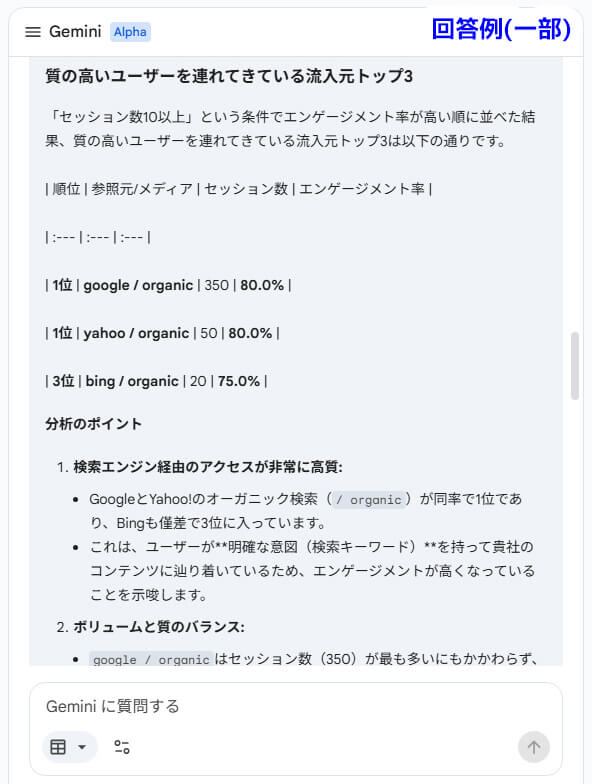

2. 質の高い集客チャネルの特定(流入元データ)

次に「流入元データ」シートを使って、「どこから来た人が、一番熱心に記事を読んでくれているか」を知り、効率的な集客を目指します。

質の高い流入元の特定(コスパの良い集客)

セッション数(量)だけでなく、エンゲージメント(質)が高い流入元を探します。

手順: 「流入元データ」シートのデータ範囲を選択し、以下のプロンプトを入力します。

セッション数が一定以上(例: 10以上)ある中で、最もエンゲージメント率が高く、質の高いユーザーを連れてきている流入元トップ3はどこですか?

得られる分析: 「Google検索(SEO)は数は多いが、実は特定のSNSやメルマガからの流入の方が、熱心に記事を読んでくれている」といった、隠れた「得意ルート」が見つかります。

3. コンテンツ改善・リライト候補の選定(記事ランキング)

最後に「記事ランキング」シートです。ここが最もSEO効果が高い分析です。「どの記事を直すべきか」をAIに見つけてもらいます。

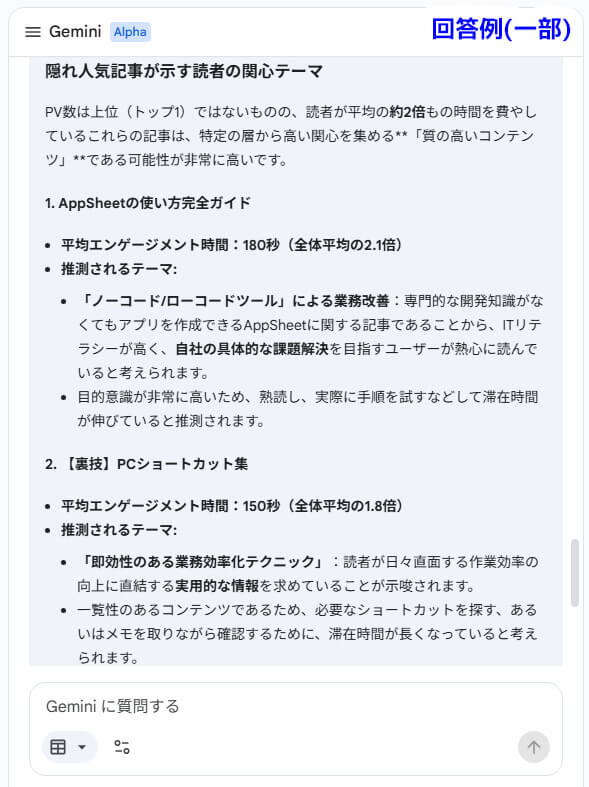

「隠れ人気記事」の発掘(リライト候補)

PV数はトップ層ではないものの、読んだ人の満足度が高い記事は、少し手直しするだけで化ける可能性があります。

手順: 「記事ランキング」シートのデータ範囲を選択し、以下のプロンプトを入力します。

これらの記事は、読者の関心が高い『隠れ人気記事』の可能性があります。どのようなテーマの記事ですか?

得られる分析: じっくり読まれている記事は、タイトルや導入文を改善してクリック率を上げたり、情報を最新化(リライト)することで、サイトの主力記事に育つ可能性があります。

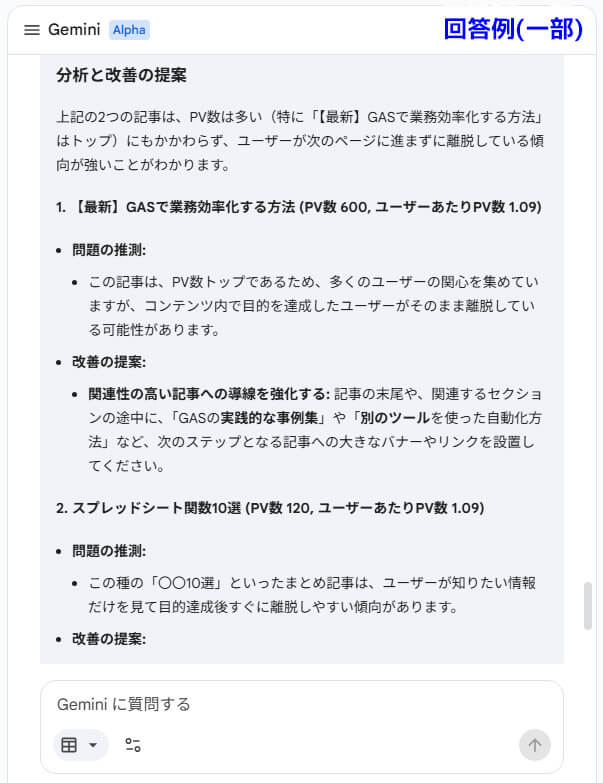

回遊率の低い記事の特定(内部リンク強化)

「読まれているのに、1ページだけで帰ってしまっている記事」もったいないですよね。

手順: 「記事ランキング」シートのデータ範囲を選択し、以下のプロンプトを入力します。

その記事は、他の記事への誘導が不足している可能性があります。リストアップしてください。

得られる分析: 「この記事を読んだ人は、他の記事を読まずに帰っている」と分かるので、「関連記事へのリンクを増やそう」「文末にオススメ記事を貼ろう」という具体的な改善策が打てます。

まとめ

全3回にわたり、GASとGA4 APIを連携し、分析まで行う方法をご紹介しました。

- 第1回: GCPの設定とGASの連携により、自動化の土台を作成。

- 第2回: 3種類のGA4データを記録するスクリプトを作成。

- 第3回: 「トリガー」で完全自動化し、AIで具体的なサイト改善を分析。

これで、「メンテナンス不要で、毎日自動で最新のレポートが更新され、AIが分析をサポートしてくれる仕組み」が完成しました。

集計作業に使っていた時間は、これからは「どの記事をリライトしようか?」「次はどんな発信をしようか?」という、本来すべきサイト改善や記事作成の時間に使ってください。

本連載が、あなたの業務効率化とサイト成長の第一歩になれば幸いです。

「手順通りやったけどうまく動かない」「もっと自社独自のデータを取りたい」といったご相談はありませんか?いわてデジタル活用室では、ツールの導入支援やカスタマイズのご相談も承っています。お気軽にお問い合わせください。

GA4自動集計&分析 の記事一覧

- 第1回:GASでGA4データを自動取得!設定と連携の手順

- 第2回:GASでGA4データを自動記録!コピペで動くスクリプトと権限の承認

- 第3回:GA4の記録を完全自動化!トリガー設定とAI分析・活用術

コメント